Et si tout le monde pouvait s’improviser artiste ? Depuis cette année, plusieurs noms ont fait une entrée fracassante dans le domaine de la génération d’images à partir d’informations textuelles (text-to-image), comme les intelligences artificielles DALL-E 2 ou encore MidJourney. Pour autant, est-ce la fin des créateurs tels que nous les connaissons ?

Tout ne semble pas aussi simple. Un outil aussi récent suscite encore de nombreuses interrogations, aussi bien sur le plan éthique que juridique. Cependant, différentes applications concrètes apparaissent déjà au sein du monde professionnel, et amorcent des tendances qui tendront vers de possibles standardisations de cette technologie.

Qu’est ce que le text-to-image ?

Cette technologie permet à n’importe qui de créer n’importe quelle image à partir d’une phrase écrite. En vous inscrivant sur un simple site internet, il suffit d’entrer quelques mots dans une barre de recherche, et l’IA crée pour vous un visuel correspondant à votre demande.

Parmi les principaux acteurs de ce domaine, nous retrouvons DALL-E 2, créé par l’entreprise OpenAI, spécialisée dans la reproduction de visuels réalistes, ainsi que MidJourney, de l’entreprise du même nom, davantage tournée vers la création d’œuvres artistiques. Mais d’autres concurrents imposants pourraient bientôt faire leur entrée sur le marché, comme Google avec Imagen, bien que son IA ne soit pas encore accessible pour le moment.

L’IA face à l’artiste

Un gain d’efficacité

En voyant une technologie comme le text-to-image débarquer et rendue accessible à qui le veut, il est logique de la considérer comme une potentielle menace pour les professionnels de la création.

En effet, dans le cas de DALL-E 2 comme celui de MidJourney, la génération d’une image ne prend tout au plus que quelques minutes. Pour une entreprise, un tel outil est un gain de temps considérable, en comparaison au temps de travail nécessaire à un graphiste, par exemple. N’importe qui peut obtenir un résultat satisfaisant et correspondant au style recherché, du moment qu’il est en mesure de s’adresser correctement à l’IA. Et si le visuel obtenu n’est pas parfait, il suffit de renouveler la demande en modifiant certains paramètres. Fini les allers-retours incessants entre les graphistes et les chefs de projets.

Mais est-ce de l’art ?

D’un autre côté, il est possible de penser que l’IA n’apporte pas la même sensibilité qu’un artiste humain. Mais là encore, tout n’est pas aussi simple. Un exemple ayant beaucoup fait parler de lui est l’œuvre Théâtre d’Opéra Spatial, de Jason M. Allen, présentée au concours de la Colorado State Fair Fine Arts Competition s’étant déroulé en juin 2022.

En effet, cette œuvre a remporté le premier prix du concours, alors qu’aucun des membres du jury et des autres participants ne savait qu’elle avait été générée par MidJourney. Les réactions n’ont pas manqué, mais cet exemple est surtout intéressant pour les questionnements qu’il soulève. Si une image créée par IA est capable de gagner un concours, c’est qu’elle peut susciter des émotions, et exprimer une singularité particulière.

Dans ce sens, l’IA intègre les mêmes avantages que l’être humain, à savoir une certaine sensibilité et une capacité à répondre à une demande dans un cadre donné, mais dans un temps plus court, ce qui en fait un concurrent direct pour les professionnels de la création. À l’inverse, certains avancent l’argument que l’IA n’est qu’un outil parmi d’autres comme l’appareil photographique l’a été pour le photographe. Sans créateur, l’IA n’est pas capable de s’autoalimenter … pour l’instant.

Les risques d’une utilisation massive

La sécurité au premier plan

D’abord ouvertes à un public restreint, DALL-E 2 et MidJourney ont fini par être rendues accessibles à tous. Mais cette utilisation à grande échelle n’est pas sans risques ni questionnements éthiques.

En prenant l’exemple de DALL-E 2, cette IA a été entrainée à générer des images les plus réalistes possibles, et les résultats sont bluffants. La première préoccupation d’OpenAI a donc été de limiter les dérives potentielles d’une telle technologie (deepfakes, pornographie, contenu violent, etc.). En effet, s’il est possible de représenter une personnalité publique, comme un Président dans n’importe quelle situation de manière réaliste, comment démêler le vrai du faux ?

La sécurité a donc été l’un des axes majeurs du développement de DALL-E 2, et les images réalistes générées possèdent volontairement des imperfections afin de pouvoir les identifier comme produites par une IA.

Du côté de Google, cet aspect sociétal des IA de génération d’images à partir de texte est pris très au sérieux. La société souhaite s’assurer de la parfaite sécurité de son service avant de l’ouvrir au plus grand nombre.

L’IA nous met face à nos clichés

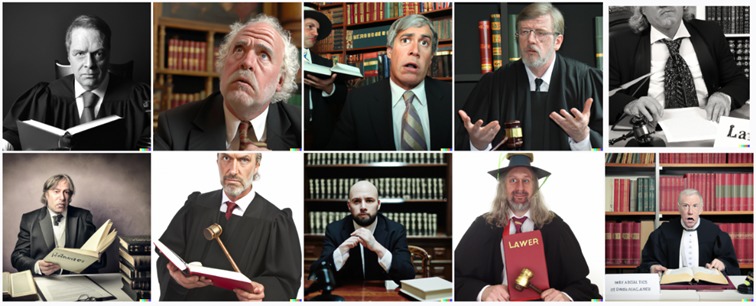

Dans un second temps, l’utilisation du text-to-image soulève un problème de représentation et d’imaginaire collectif, comme le présente l’article DALL·E 2 Preview – Risks and Limitations, par Pamela Mishkin, chercheuse chez OpenAI. Dans le cas de DALL-E 2, lorsque l’utilisateur demandait à l’IA de générer l’image d’un juge, ce dernier affichait plusieurs propositions souvent similaires : un homme blanc, occidental, assez âgé. En revanche, en demandant à l’IA l’image d’une infirmière (nurse en anglais dont le genre est neutre), c’était une femme qui était présentée. Ce comportement de l’IA a généré plusieurs réactions quant aux représentations sexistes et ethnocentrées.

Les stéréotypes de la culture occidentale ressortent également dans des expériences menées par certains utilisateurs de MidJourney. C’est le cas de @jjonnyynnojj sur TikTok, mis en avant dans l’article À l’aide d’une IA, il représente 50 pays du monde comme s’ils étaient des humains. La publication des résultats a beaucoup fait réagir, notamment pour certains pays dont la représentation est faite d’une manière très stéréotypée, une vision du monde fortement occidentale.

Ces représentations mettent en avant les clichés de nos sociétés. C’est ce qu’affirme Morgan King dans son article Harmful biases in artificial intelligence du magazine « Correspondence », en prenant l’exemple de la schizophrénie.

En entrant le mot « schizophrénie » dans MidJourney, il s’est rendu compte que l’IA proposait des résultats représentant un mal-être mental, la folie, ou encore un dédoublement de la personnalité. Mais ces résultats sont loin de la réalité et correspondent aux stéréotypes communs que nous avons de cette maladie psychique, cela étant dû aux données utilisées afin d’entrainer l’IA de MidJourney. L’imaginaire collectif se révèle à travers l’IA, mais au détriment de la représentativité de certaines minorités. Les sociétés de développement d’IA en ont conscience, comme l’indique Imagen sur son site : les données « reflètent souvent des stéréotypes sociaux, des points de vue oppressifs et des associations dérogatoires ou autrement nuisibles aux groupes d’identité marginalisés. »

Quelles solutions ?

Plusieurs solutions ont donc été avancées pour pallier ces risques et faiblesses. Face aux problèmes des deepfakes, après une beta fermée et plusieurs ajustements, DALL-E 2 engage ses utilisateurs avec la signature d’une charte éthique, et interdit de diffuser une image générée sans son bandeau signifiant qu’elle provient du site. D’autre part, OpenAI a rapidement corrigé le manque de diversité de ses images générées, pour donner suite aux remarques des utilisateurs.

Ces différents exemples questionnent la responsabilité dans la création de ces images. Est-ce l’utilisateur, ou bien les entreprises à l’origine de l’IA qui sont mis en cause lorsqu’un contenu généré pose problème ? Aucune législation n’est encore fixée sur le sujet.

D’autre part, l’exemple de la diversité des profils présentés par l’IA nous montre que cette dernière est avant tout politique, et dépend des choix faits par les entreprises. Il s’agira donc d’un enjeu non négligeable dans la commercialisation de cette technologie à l’échelle mondiale.

La question des droits d’auteur ?

À qui appartiennent les images générées ?

Si des IA comme DALL-E 2 ou MidJourney permettent de multiplier la création de nouvelles images, il est légitime de se poser la question : à qui appartiennent-elles ?

En effet, l’arrivée rapide de ces nouveaux outils n’a pas encore laissé le temps au droit d’auteur de s’y adapter. Est-ce donc l’entreprise à l’origine de l’IA qui en détient les droits, ou bien l’utilisateur qui a su générer l’image ?

Dans le cas de DALL-E 2, les pleins droits reviennent à l’utilisateur ayant généré l’image, incluant le droit de la commercialiser, ce qui n’était pas autorisé au départ par OpenAI. Du côté de MidJourney, l’utilisateur possède également un copyright sur les images qu’il crée. Pourtant, ces questions sont loin d’être tranchées.

Et les données utilisées ?

Cependant, comme le soulève Bastien L. dans un article intitulé MidJourney : tout savoir sur l’IA qui choque les artistes et transforme vos textes en dessins, « des problèmes de propriété intellectuelle pourraient survenir concernant les modèles IA entrainés sur du matériel soumis à des droits d’auteur. »

En effet, une œuvre générée par IA pourrait présenter des similitudes avec d’autres œuvres sur lesquelles elle a été entrainée, et ainsi être accusée de plagiat. Parmi les forces des logiciels mentionnés, celle d’être en mesure de s’approprier et d’imiter le style des artistes est l’une des plus puissantes. Ainsi, une simple commande permet de produire une image en imitant le style de Van Gogh. Si ce dernier n’a plus vraiment de raison de s’inquiéter de cette fonctionnalité, les artistes vivants s’alarment de cette capacité à imiter leur style. Pour contrer cela, Glaze est une intelligence artificielle développée par l’Université de Chicago qui a pour objectif de protéger les artistes du plagiat des IA. Le principe est simple : le logiciel modifie, à la marge, les créations artistiques. Il s’agit d’un algorithme de « transfert de style » qui identifie les caractéristiques d’une œuvre pour en modifier quelques-unes très subtilement (invisible à l’œil nu), mais suffisamment pour que les IA de MidJourney et DALL-E2 soient dans l’incapacité d’imiter le style de l’artiste.

D’autre part, l’utilisation d’images existantes pour entrainer une IA questionne l’utilisation de ces données. Les artistes ne doivent-ils pas être rémunérés pour avoir fourni des œuvres et ainsi permettre le développement des IA text-to-image ?

Des cas concrets commencent à émerger, comme l’affaire présentée par l’article de Thierry Maubant, Getty Images se retourne contre Stability AI pour non-respect de la propriété intellectuelle. La start-up londonienne Stability AI aurait entrainé son service sur une banque d’images soumises au droit d’auteur, sans en informer celle-ci. On peut également remarquer que malgré le manque d’encadrement juridique, certains accords se mettent déjà en place entre à travers des « Licences » accordées par les banques d’images aux entreprises d’IA.

Pour revenir à l’article de Bastien L., celui-ci précise que « les créateurs de MidJourney reconnaissent que la loi n’est pas encore suffisamment claire concernant le contenu généré par IA. Il s’attend à ce que des lois plus spécifiques soient adoptées dans le futur. »

Les prémices d’un nouvel outil

Des modèles de monétisation

La question de la monétisation est également un enjeu central dans le développement d’IA comme DALL-E 2 ou MidJourney.

Comme l’explique l’article DALL-E 2 enfin disponible pour tous ! Comment créer de l’art avec l’IA Text-to-Image ? sur le site LeBigData, il est déjà possible de voir certains modèles se dessiner, comme pour DALL-E 2 qui rend son service accessible via un système de crédits. L’utilisateur reçoit 50 crédits à son inscription, puis 15 crédits par mois, qu’il peut dépenser pour générer des images. Ces derniers sont également achetables en ligne, si l’utilisateur souhaite créer davantage d’images.

En parallèle, de nombreux services text-to-image voient le jour en ligne. Plus ou moins performants, ils reposent en grande majorité sur le modèle de premiers essais gratuits, avant de rediriger l’utilisateur vers un abonnement payant, donnant accès à davantage de contenu. Parmi ceux-ci, nous pouvons citer DeepAI, Nightcafe, StarryAI, etc.

De cette manière, le text-to-image devient un service similaire à de nombreux autres, basé sur un modèle économique déjà existant.

Vers une standardisation du text-to-image

Un autre exemple est celui de Microsoft Designer, annoncé par Microsoft le 12 octobre lors de son Surface Event 2022. Cette application de création visuelle pour professionnels intègre directement l’IA DALL-E 2 afin de générer des images et templates. L’objectif annoncé par l’entreprise n’est pas de remplacer les professionnels, mais de les aider à gagner en temps et en créativité.

Ce phénomène est également observable chez d’autres services en ligne, comme Canva ou Picsart. L’IA directement intégrée à ces outils de création graphique permet de générer des éléments uniques ainsi que des visuels prédéfinis. Comme pour Microsoft, il s’agit d’assister les créateurs dans leur travail en l’accélérant, et en proposant de nouvelles sources d’inspiration.

Un exemple concret est celui de Mehdi Touzani, auteur de la bande dessinée Le Voyage de Ravine, entièrement dessinée par une IA, avec des retouches de l’auteur. Présentée dans l’article « Le Voyage à Ravine » de Mehdi Touzani, la première BD française créée par l’intelligence artificielle, de Oussama Karfa et Kelian Nguyen, la réalisation de ce projet témoigne de la manière dont l’IA vient compléter le travail des professionnels de la création.

Ainsi, nous pourrions supposer que des technologies comme MidJourney ou DALL-E 2 viendraient à se standardiser en intégrant des logiciels de travail, principalement destinés au monde professionnel. Ils seraient comparables à des outils comme la suite Adobe ou Office, et assisteraient l’être humain dans ses tâches.

Cependant, l’utilisation de ces outils requiert également de nouveaux savoir-faire. En effet, pour obtenir le résultat voulu, il faut être capable d’entrer les bons mots-clés, ce qui nécessite des compétences différentes par rapport à celles d’un graphiste par exemple. Ces mutations amèneront donc certainement à l’apparition de nouveaux métiers.

Déjà l’étape supérieure ?

De nombreux acteurs se sont également lancés dans la course des IA de génération d’images, comme Google avec Imagen. Mais cet effet de révolution apporté par le text-to-image pourrait être vite contrebalancé par un nouveau concurrent : la génération vidéo.

En effet, l’article Oubliez Dall-E, Meta génère carrément des vidéos avec un simple texte du site Frandroid, met en lumière le choix fait par le groupe Meta de se positionner sur la génération de vidéos à partir de texte. Le groupe a déjà présenté son IA Make-A-Video, qui n’est pas encore accessible pour le moment.

Cette avancée semble donc être la prochaine étape à surveiller, et pourrait révolutionner de nombreux secteurs professionnels, comme s’apprêtent à le faire DALL-E 2 et MidJourney.

Cette note de veille a été rédigée par les étudiants de l’ISIC Bordeaux Montaigne : Léo Giraudeau, Maëva Moreira, Elodie Tapsoba et Lucie Wachez, supervisés par Alexandre Bertin, Responsable Veille et Prospective à Unitec.